Issue (11): 2979-2984,2992??DOI:10.11772/j.issn.1001-9081.2016.11.2979

引用本文

陸中秋, 侯振杰, 陳宸, 梁久禎. 基于深度圖像與骨骼數(shù)據(jù)的行為識別[J].計算機(jī)應(yīng)用, 2016, 36(11): 2979-2984,2992.DOI:10.11772/j.issn.1001-9081.2016.11.2979.

LU Zhongqiu, HOU Zhenjie, CHEN Chen, LIANG Jiuzhen. Action recognition based on depth images and skeleton data[J]. Journal of Computer Applications, 2016, 36(11): 2979-2984,2992. DOI:10.11772/j.issn.1001-9081.2016.11.2979.

基金項(xiàng)目

國家自然科學(xué)基金資助項(xiàng)目(61063021)粪薛;江蘇省產(chǎn)學(xué)研前瞻性聯(lián)合研究項(xiàng)目(BY2015027-12)

通信作者

侯振杰(1973-), 男, 內(nèi)蒙古包頭人, 教授, 博士, CCF會員, 主要研究方向:機(jī)器視覺告私、機(jī)器學(xué)習(xí),houzj@cczu.edu.cn

作者簡介

陸中秋(1991-), 男, 江蘇張家港人, 碩士研究生, CCF會員, 主要研究方向:行為識別;

陳宸(1982-), 男, 江蘇常州人, 博士, 主要研究方向:數(shù)字圖像處理、機(jī)器學(xué)習(xí);

梁久禎(1968-), 男, 山東濟(jì)南人, 教授, 博士, CCF會員, 主要研究方向:機(jī)器視覺

文章歷史

收稿日期:2016-06-07

修回日期:2016-06-27

ContentsAbstractFull textFigures/TablesPDF

基于深度圖像與骨骼數(shù)據(jù)的行為識別

常州大學(xué) 信息科學(xué)與工程學(xué)院, 江蘇 常州 213164

收稿日期:2016-06-07 ;修回日期:2016-06-27

基金項(xiàng)目:國家自然科學(xué)基金資助項(xiàng)目(61063021)脉让;江蘇省產(chǎn)學(xué)研前瞻性聯(lián)合研究項(xiàng)目(BY2015027-12)

作者簡介:陸中秋(1991-), 男, 江蘇張家港人, 碩士研究生, CCF會員, 主要研究方向:行為識別;

陳宸(1982-), 男, 江蘇常州人, 博士, 主要研究方向:數(shù)字圖像處理枣抱、機(jī)器學(xué)習(xí);

梁久禎(1968-), 男, 山東濟(jì)南人, 教授, 博士, CCF會員, 主要研究方向:機(jī)器視覺

通訊聯(lián)系人:侯振杰(1973-), 男, 內(nèi)蒙古包頭人, 教授, 博士, CCF會員, 主要研究方向:機(jī)器視覺、機(jī)器學(xué)習(xí),houzj@cczu.edu.cn

摘要: 為了充分利用深度圖像與骨骼數(shù)據(jù)進(jìn)行人體行為識別姆钉,提出了一種基于深度圖形與骨骼數(shù)據(jù)的多特征行為識別方法。該算法的多特征包括深度運(yùn)動圖(DMM)特征與四方形骨骼特征(Quad)抄瓦。深度圖像方面潮瓶,將深度圖像投影到一個笛卡爾坐標(biāo)系的三個平面獲得深度運(yùn)動圖特征。骨骼數(shù)據(jù)方面钙姊,提出四方形骨骼特征训唱,它是骨骼坐標(biāo)的一種標(biāo)定方式悯姊,得到的結(jié)果只與骨骼姿態(tài)有關(guān)。同時提出一種多模型概率投票的分類策略,減小了噪聲數(shù)據(jù)對分類結(jié)果的影響炮温。所提方法在MSR-Action3D和DHA數(shù)據(jù)庫進(jìn)行實(shí)驗(yàn),實(shí)驗(yàn)結(jié)果表明精堕,所提算法有著較高的識別率與良好的魯棒性绰更。

關(guān)鍵詞:深度圖像骨骼數(shù)據(jù)行為識別深度運(yùn)動圖四方形骨骼特征

Action recognition based on depth images and skeleton data

LU Zhongqiu,HOU Zhenjie,CHEN Chen,LIANG Jiuzhen

School of Information Science & Engineering, Changzhou University, Changzhou Jiangsu 213164, China

Background: This work is partially supported by the National Natural Science Foundation of China (61063021), Industry, Teaching and Research Prospective Project of Jiangsu Province (BY2015027-12)

LU Zhongqiu, born in 1991, M. S. candidate. His research interests include action detection, machine learning.

HOU Zhenjie, born in 1973, Ph.D., professor. His research interests include computer vision, machine learning

CHEN Chen, born in 1982, Ph.D.. His research interests include signal and image processing

LIANG Jiuzhen, born in 1969, Ph.D., professor. His research interests include computer vision

Abstract: In order to make full use of depth images and skeleton data for action detection, a multi-feature human action recognition method based on depth images and skeleton data was proposed. Multi-features included Depth Motion Map (DMM) feature and Quadruples skeletal feature (Quad). In aspect of depth images, DMM could be captured by projecting the depth image onto the three plane of a Descartes coordinate system. In aspect of skeleton data, Quad was a kind of calibration method for skeleton features and the results were only related to the skeleton posture. Meanwhile, a strategy of multi-model probabilistic voting model was proposed to reduce the influence from noise data on the classification. The proposed method was evaluated on Microsoft Research Action 3D dataset and Depth-included Human Action (DHA) database. The results indicate that the method has high accuracy and good robustness.

Key words:depth imageskeleton dataaction recognitiondepth motion mapQuadruples skeletal feature (Quad)

0 引言

行為識別是計算機(jī)視覺與模式匹配中的一個熱門問題, 每天人們都會遇到許多潛在的人機(jī)交互。盡管這些年許多學(xué)者對行為識別做了許多卓越的貢獻(xiàn), 識別人類行為仍然是一個巨大的挑戰(zhàn)婚温。

早期的行為識別主要對視頻進(jìn)行處理描焰。隨著圖像技術(shù)與硬件的發(fā)展, 利用微軟Kinect或華碩Xtion等設(shè)備, 學(xué)者可以實(shí)時獲取人體的深度圖像信息。與傳統(tǒng)的圖像相比, 深度圖像不受光照影響, 能夠提供三維空間信息栅螟。利用深度圖像, 學(xué)者們對行為識別做了許多研究, 例如文獻(xiàn)[1-3]荆秦;同時, 深度攝像頭設(shè)備通過對深度數(shù)據(jù)的處理, 提取出了人體的骨骼特征[4], 為行為識別提供的重要的行為特征。

本文提出一種基于深度運(yùn)動圖數(shù)據(jù)與骨骼數(shù)據(jù)的融合識別方法力图。通過深度攝像頭(RGB-Depth, RGBD)可以獲取一個行為的一系列深度圖像步绸。將這一系列的深度圖在3個視圖方向(前視圖、左視圖吃媒、俯視圖)上投影獲取深度運(yùn)動圖, 并對得到的深度運(yùn)動圖進(jìn)行局部二值模式(Local Binary Pattern, LBP)預(yù)處理, 只獲取其紋理信息瓤介;同時對骨骼數(shù)據(jù)進(jìn)行四方形坐標(biāo)標(biāo)定,利用Fisher對得到的骨骼數(shù)據(jù)進(jìn)行預(yù)處理赘那;最后將得到的深度運(yùn)動圖與骨骼特征輸入到一個基于支持向量機(jī)(Support Vector Machine, SVM)的多模型概率投票的分類器中惑朦。本文在行為識別方面有2點(diǎn)貢獻(xiàn):1)?將深度圖像信息與骨骼信息結(jié)合作為行為的數(shù)據(jù)特征;2)?提出了基于SVM的多模型概率投票機(jī)制, 很大程度上克服了噪聲數(shù)據(jù)對模型的影響, 提高了識別率, 具有一定的魯棒性漓概。

對于傳統(tǒng)的彩色攝像頭采集的圖像, 學(xué)者們大多利用其時空特征與軌跡進(jìn)行行為識別:文獻(xiàn)[5]利用時空點(diǎn)與SVM配合識別人體行為漾月;文獻(xiàn)[6]利用尺度不變的軌跡作為特征, 在3層的抽象等級上識別行為;文獻(xiàn)[7]提出了在視頻序列中提取運(yùn)動能量圖(Motion Energy Image, MEI)和運(yùn)動歷史圖(Motion History Image, MHI)作為行為特征胃珍。使用圖像強(qiáng)圖或者顏色的一個主要缺點(diǎn)使其對光照變化敏感, 限制了算法的魯棒性梁肿。蔡加欣等[8]對人體輪廓進(jìn)行研究, 基于隨機(jī)森林方法, 提出基于袋外數(shù)據(jù)誤差加權(quán)投票準(zhǔn)則的行為視頻分類方法蜓陌。

隨著RGBD攝像頭的發(fā)展, 學(xué)者們已經(jīng)提出許多基于深度圖像的行為識別算法:文獻(xiàn)[9]利用金字塔模型與3D點(diǎn)的詞袋模型作為行為姿態(tài)的行為特征; 文獻(xiàn)[10]將深度圖像投影到3個正交的平面上形成深度運(yùn)動圖(Depth Motion Map, DMM), 然后用提取其梯度直方圖(Histogram Of Gradient, HOG)作為行為的特征; 文獻(xiàn)[11]從深度視頻中提取隨機(jī)占用模式(Random Occupancy Pattern, ROP)特征, 并用稀疏編碼技術(shù)進(jìn)行重新編碼; 鄭胤等[12]介紹了深度學(xué)習(xí)及其目標(biāo)和行為識別中的新進(jìn)展。

隨著對深度圖像進(jìn)一步的處理, 學(xué)者們提取出其中高層次的骨骼信息, 基于骨骼信息的算法可以更加直接地描述人體行為:文獻(xiàn)[1]將人體定位到3D空間箱子模型, 提取人體的3D骨骼點(diǎn)直方圖(Histogram Of 3D Joint, HOJ3D)作為行為特征; 文獻(xiàn)[13]提出從人體骨骼節(jié)點(diǎn)的拓?fù)浣Y(jié)構(gòu)中選取最有子集來提高識別率; 文獻(xiàn)[14]提出了一種生物啟發(fā)的三維骨骼特征的時空層次結(jié)構(gòu); 文獻(xiàn)[2]使用樸素貝葉斯近鄰分類器識別人體骨骼特征點(diǎn)的靜態(tài)與動態(tài)信息吩蔑。

與傳統(tǒng)單一的特征數(shù)據(jù)模型相比, 多特征有著良好的優(yōu)勢钮热。文獻(xiàn)[15]提出了跨數(shù)據(jù)模型的融合實(shí)驗(yàn), 在IXMAS(INRIA Xmas Motion Acquisition Sequences)等數(shù)據(jù)庫做了實(shí)驗(yàn)。在大數(shù)據(jù)環(huán)境下, 多特征協(xié)同識別成為人體行為識別趨勢烛芬。結(jié)合深度圖像與骨骼數(shù)據(jù), 可以提高識別的準(zhǔn)確性隧期。

1 運(yùn)動特征描述1.1 深度運(yùn)動圖特征

深度圖像可以用來表示物體3D結(jié)構(gòu)和形狀信息。文獻(xiàn)[10]提出將深度圖像時間序列中的每一幀投影到正交的3個笛卡爾面來表示這個行為動作赘娄。具體地說, 使用三視圖中的主視圖仆潮、俯視圖和左視圖, 將人體定位到笛卡爾坐標(biāo)系, 分別將人體深度數(shù)據(jù)投影到主視圖、俯視圖和左視圖遣臼。每一幀行為可以表示為v={f,s,t}, 其中:f性置、s、t分別表示在主視圖揍堰、左視圖和俯視圖的人體投影鹏浅。與文獻(xiàn)[2]不同, 每個投影的圖是由2個連續(xù)的深度圖像幀做差投影得到。對于N幀的深度數(shù)據(jù)視頻, 由式(1)計算出它的DMMv特征:

DMMv=∑i=ab|mapvi?mapvi?1|(1)

其中:i表示時間序列幀屏歹;mapvi表示在第i幀下的隐砸、在視圖v上的投影;a和b分別表示開始幀和結(jié)束幀蝙眶。

但是并不是所有深度圖中的像素都需要被投影, 深度圖像中很多像素值為0, 對行為特征描述沒有幫助凰萨。所以要對每一幀圖像進(jìn)行感興趣區(qū)域(Region Of Interest, ROI)操作。即裁剪圖像, 使主要內(nèi)容平鋪在整個圖像上, 且保證圖像大小一致械馆。為了進(jìn)一步對DMMv中的像素進(jìn)行過濾, 對DMMv進(jìn)行局部二值模式(LBP)操作。LBP是一種用來描述圖像局部紋理特征的算法, 可以提取DMMv中的紋理信息, 增加了特征的稀疏性武通。如圖 1, 對于在圖像上個給定的一點(diǎn)gc, 式(2)為LBP的計算公式:

LBPm,r(gc)=∑i=1mU(gi?gc)2i(2)

圖 1{gi}i=18示意圖(r=1)

其中:U(x)={1,x?00,x<0霹崎;m為采樣點(diǎn)個數(shù),U(x)為判別函數(shù)。具體過程為:若gc的坐標(biāo)是(xc,yc), 其半徑為r的m個近鄰采樣點(diǎn)冶忱。

{gi}i=1m的坐標(biāo)可以表示為:

(xc?rsin?(2πi/m),yc+rcos?(2πi/m))

經(jīng)過式(2)計算出gc的m位的LBP編碼作為gc的新數(shù)值, 那么圖像就變?yōu)槿?a target="_blank" rel="nofollow">圖 2(d), 統(tǒng)計得到圖像的直方圖hv尾菇。

圖 2深度運(yùn)動圖特征形成過程

以側(cè)踢為例子, 如圖 2,圖 2(a)表示一個側(cè)踢運(yùn)動的深度圖像序列。DMMf的大小為mf×nf,DMMs的大小為ms×ns,DMMt的大小為mt×nt囚枪。因?yàn)槭怯孟袼刂底鳛樘卣? 為了避免大像素值對模型的影響, 將DMMv歸一化到[0, 1], 同時進(jìn)行ROI, 保證圖像大小一致, 表示為DMMvˉ, 則踢腿特征可以表示為h=LBP(DMMvˉ),h的大小為(mf′×nf′+ms′×ns′+mt′×nt′)×1派诬。

1.2 骨骼特征(Quad)

由于微軟的Kinect提供的骨骼數(shù)據(jù)帶來的便利, 可以直接獲取人體的20個骨骼節(jié)點(diǎn)。根據(jù)文獻(xiàn)[16]所提出的四方形骨骼表示法對骨骼點(diǎn)進(jìn)行處理, 如圖 3所示链沼。x∈R3表示在真實(shí)世界坐標(biāo)系下人的骨骼點(diǎn)坐標(biāo)默赂。則X=[X1,X2,X3,X4]。X1與X2為相距較遠(yuǎn)的點(diǎn)括勺。以X1作為原點(diǎn),X2映射到[1, 1, 1]T, 構(gòu)建本地坐標(biāo)系缆八。當(dāng)這2個點(diǎn)確定后, 剩下的2個點(diǎn)則可以用如下公式計算出:

S(xi)=sR[xi?x1](3)

圖 3四方形骨骼表示

其中:s表示縮放矩陣,R表示旋轉(zhuǎn)矩陣曲掰。令S(X1)=[0, 0, 0]T,S(X2)=[1, 1, 1]T, 則當(dāng)前4個骨骼點(diǎn)特征可表示為q=[S(X3);S(X4)], 其大小為6×1, 如圖 3。

取圖 3(a)左臂4個節(jié)點(diǎn)作為一個四方形骨骼表示點(diǎn)奈辰。相距較遠(yuǎn)的2個點(diǎn)分別作為(0, 0, 0)和(1, 1, 1), 則該4點(diǎn)的特征表示為q=[x3,y3,z3,x4,y4,z4]T栏妖。

由于能檢測到的人體關(guān)節(jié)見有20個, 即存在的四方形骨骼特征有C204=4 845個。對于一個k幀的行為動作, 特征可表示為:

Q={qji|i∈(1,C204)|,j∈(1,k)}(4)

由于Q的大小與k有關(guān), 而每個動作的k又不同, 導(dǎo)致每個行為的骨骼特征大小不同奖恰。為了避免這個問題, 對Q進(jìn)行Fisher處理吊趾。由文獻(xiàn)[17]可知, 利用高斯混合模型的Fisher, 可以將Q轉(zhuǎn)換為Fisher向量F。F的大小為2fd×1瑟啃。f在本文高斯混合模型中取128,d為Q的行數(shù)量, 在本文為6, 即F的大小為1 536×1论泛。

2 基于SVM的概率投票行為識別

單個的SVM只能解決二分類問題, 對于多分類的問題, 可以使用多個SVM分類器聯(lián)合分類, 包括一對一、一對多等方法翰守。雖然直接分類的SVM是一個強(qiáng)有力的機(jī)器學(xué)習(xí)的分類工具, 然而在實(shí)際應(yīng)用中, 由于噪聲的影響, 每個樣本對分類結(jié)果的影響應(yīng)該是不同的孵奶。直接將結(jié)果分類成0和1可能并不恰當(dāng)。為了使SVM更加適應(yīng)這些問題, 要求SVM具有軟輸出的功能, 即輸出概率蜡峰。本文的SVM概率投票分類就是基于輸出概率進(jìn)行的了袁。

給定的行為識別特征數(shù)據(jù)包括深度運(yùn)動圖特征與四方形骨骼特征。其中深度運(yùn)動圖特征包括v={f,s,t}三個方向的特征湿颅。對于三個方向的深度運(yùn)動圖特征與骨骼特征, 對各個特征進(jìn)行SVM概率建模, 將得到的模型進(jìn)行累加投票, 得到最大目標(biāo)可能概率, 即為最后輸出標(biāo)簽载绿。

Label=max(∑ModelSVM(E));E∈{v,F}(5)

v代表前視圖、左視圖與俯視圖三個方向油航。F代表骨骼數(shù)據(jù)在Fisher操作后的骨骼特征崭庸。如圖 4, 對于每個特征進(jìn)行SVM分類, 得到各個特征的模型。與以往的SVM不同, 該訓(xùn)練的幾個模型輸出均為識別概率谊囚。將概率累加, 獲取最大概率的標(biāo)簽即為結(jié)果怕享。

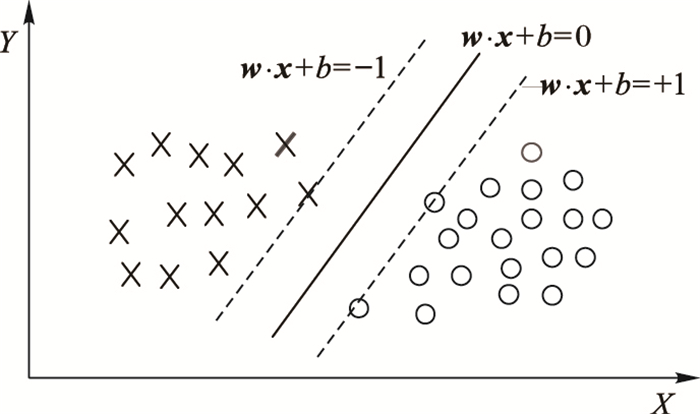

圖 4SVM二分類

SVM是機(jī)器學(xué)習(xí)中的強(qiáng)有力的學(xué)習(xí)方法。傳統(tǒng)的SVM是解決單分類問題镰踏。SVM試圖找出一個超平面, 使超平面能夠盡量多地分隔出兩類函筋。經(jīng)過大量實(shí)驗(yàn)證明, SVM在小樣本集上有著卓越的優(yōu)勢。

如圖 4所示奠伪。SVM希望在這兩類中找出一個平面跌帐。如式(6),f(x)大于0對應(yīng)y=1,f(x)小于0對應(yīng)y=-1。

f(x)=w?x+b(6)

為了SVM能夠進(jìn)行概率輸出, 使用擠壓函數(shù)sigmod將f(x)映射到[0, 1], 如式(7):

p(y=1|f)=1/1+exp?(Af+B)(7)

為了保證公式的單調(diào)性, 設(shè)置A< 0绊率。通過這樣, 可以輸出帶概率的SVM分類結(jié)果谨敛。

對于多分類的概率支持向量機(jī)(Probability Support Vector Machine, PSVM), 對每個帶概率的SVM進(jìn)行一對一, 該方法在每兩類訓(xùn)練一個分類器, 因此對于一個k類問題, 將有k(k-1)/2個分類函數(shù)。當(dāng)對一個未知樣本進(jìn)行分類時, 每個分類器都對其類別進(jìn)行判斷.并為相應(yīng)的類別“投上一票”, 最后得票最多的類別即作為該未知樣本的類別滤否。決策階段采用投票法, 傳統(tǒng)的投票法可能存在多個類的票數(shù)相同的情況, 從而使未知樣本同時屬于多個類別, 影響分類精度, 基于概率輸出的投票法可以避免這方面的問題, 取得更好的效果脸狸。

由于是多特征的概率SVM投票模型, 那么需要對每個模型進(jìn)行SVM參數(shù)調(diào)優(yōu), 在每個單獨(dú)模型上, 調(diào)整SVM的準(zhǔn)確度到最優(yōu)。

與以往的SVM不同, 該訓(xùn)練的幾個模型輸出均為識別概率藐俺。將概率累加, 獲取最大概率的標(biāo)簽即為結(jié)果肥惭。這樣有如下優(yōu)點(diǎn):

1)?對不同特征進(jìn)行不同的處理, 發(fā)揮特征的最好效果盯仪。

2)?可以集成當(dāng)前效果最好的特征進(jìn)行分類, 極容易拓展。

3)?隨著計算機(jī)性能的提高, 概率投票方式不會受到計算機(jī)性能的約束, 可以達(dá)到實(shí)時的效果蜜葱。

3 實(shí)驗(yàn)結(jié)果與分析3.1 MSR-Action3D實(shí)驗(yàn)3.1.1 實(shí)驗(yàn)數(shù)據(jù)

MSR-Action3D數(shù)據(jù)庫是一個關(guān)于Kinect采集數(shù)據(jù)的行為識別庫, 其中包括10個人做20個動作: high wave(HiW)全景、horizontal wave(How)、hammer(H)牵囤、hand catch(HC)爸黄、forward punch(FP)、high throw(HT)揭鳞、draw x(DX)炕贵、draw tick(DT)、draw circle(DC)野崇、hand clap(HC)称开、two hand wave(THW)、side boxing(SB)乓梨、bend(B)鳖轰、forward kick(FK)、side kick(SK)扶镀、jogging(JO)蕴侣、tennis swing(TS)、tennis serve(TS)臭觉、golf swing(GS)昆雀、pickup throw(PT)。每個人做2~3次蝠筑∧欤總共包括557個240×320的深度圖像與557個骨骼數(shù)據(jù)。

圖 5行為識別算法流程

3.1.2 實(shí)驗(yàn)設(shè)置

設(shè)置一????與文獻(xiàn)[3]中的設(shè)置相同, 將20個行為分為3組(AS1什乙、AS2挽封、AS3), 如表 1, AS1與AS2里都是相似行為, 而AS3里則是相似度較小的行為。對每一組進(jìn)行3個實(shí)驗(yàn)稳强。在實(shí)驗(yàn)一中, 1/3作為訓(xùn)練數(shù)據(jù), 2/3作為測試數(shù)據(jù)。實(shí)驗(yàn)二中, 2/3作為訓(xùn)練數(shù)據(jù), 1/3作為測試數(shù)據(jù)和悦。實(shí)驗(yàn)三中一半數(shù)據(jù)作訓(xùn)練, 剩余一半作測試退疫。

表 1MSR-Action3D數(shù)據(jù)分組

設(shè)置二????與文獻(xiàn)[11]中設(shè)置相同, 同時使用20個行為, 一半作為訓(xùn)練數(shù)據(jù), 剩余一半作為測試數(shù)據(jù)。因?yàn)樾枰R別的類別比較多, 設(shè)置二更具有挑戰(zhàn)性鸽素。

3.1.3 實(shí)驗(yàn)結(jié)果與分析

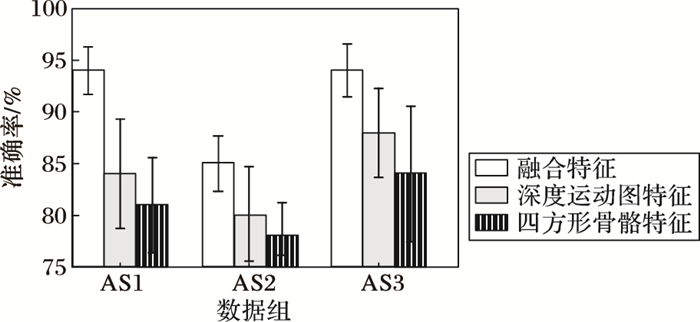

實(shí)驗(yàn)主要分為三個方面:單一特征實(shí)驗(yàn)褒繁、特征融合實(shí)驗(yàn)與穩(wěn)定性實(shí)驗(yàn)。對深度運(yùn)動圖特征馍忽、四方形骨骼特征和兩者的結(jié)合分別進(jìn)行設(shè)置二的實(shí)驗(yàn), 驗(yàn)證特征融合的必要性棒坏。同時將本算法與現(xiàn)有的其他算法進(jìn)行對比燕差。最后, 對實(shí)驗(yàn)數(shù)據(jù)進(jìn)行隨機(jī)抽樣, 測試算法的穩(wěn)定性。

單一特征實(shí)驗(yàn)????對深度運(yùn)動圖坝冕、四方形骨骼特征和兩者的融合分別進(jìn)行實(shí)驗(yàn)徒探。根據(jù)設(shè)置二的數(shù)據(jù)安排, 一半數(shù)據(jù)作為訓(xùn)練, 一半數(shù)據(jù)作為測試, 一共20類行為。比較在設(shè)置二下的各種情況的識別率喂窟。如表 2所示, 將深度運(yùn)動圖與四方形骨骼特征融合, 有著更高的識別率测暗。

表 2單一特征實(shí)驗(yàn)結(jié)果

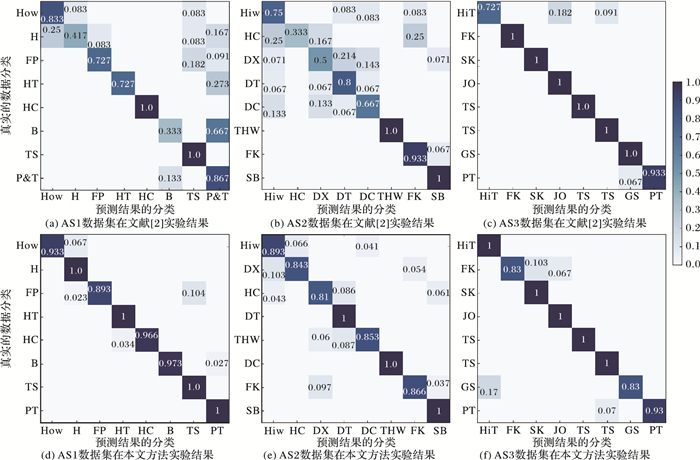

特征融合實(shí)驗(yàn)根據(jù)實(shí)驗(yàn)設(shè)置一進(jìn)行實(shí)驗(yàn), 與現(xiàn)有的方法進(jìn)行對比, 結(jié)果如表 3, 可以看出, 本文的方法在實(shí)驗(yàn)一(1/3為訓(xùn)練樣本, 2/3為測試樣本)的識別率比現(xiàn)有的方法識別率低, 對于小樣本的識別率不高。在實(shí)驗(yàn)二(2/3作為訓(xùn)練樣本, 1/3作為測試樣本)中, 本文的識別率已經(jīng)與現(xiàn)有的方法大體持平, 在AS3子集中更是達(dá)到了100%磨澡。而在實(shí)驗(yàn)三(1/2作為訓(xùn)練樣本, 包括1、3、5隶垮、6泼橘、7、9號人的行為數(shù)據(jù), 剩余作為測試樣本)中, 本文的識別率明顯高于現(xiàn)有的方法厦酬。文獻(xiàn)[2]與本文方法的混淆矩陣如圖 6所示胆描。在表 3的實(shí)驗(yàn)三中, 其具體分類準(zhǔn)確率的混淆矩陣如圖 6所示。在AS1與AS2這2個相似動作的數(shù)據(jù)子集中, 本文的方法降低了錯分率, 提高了準(zhǔn)確率弃锐。在AS3中, 本文方法對許多動作能夠完全地區(qū)分開來, 準(zhǔn)確率達(dá)到100%袄友。

圖 6文獻(xiàn)[2]方法與本文方法混淆矩陣對比

表 3設(shè)置一實(shí)驗(yàn)結(jié)果%

根據(jù)實(shí)驗(yàn)設(shè)置二進(jìn)行實(shí)驗(yàn), 與現(xiàn)有方法對比, 結(jié)果如表 4。因?yàn)閷?shí)驗(yàn)設(shè)置二將所有20類行為一起進(jìn)行訓(xùn)練識別, 實(shí)驗(yàn)設(shè)置二對于算法的識別率更具有挑戰(zhàn)霹菊。根據(jù)結(jié)果可以看出, 本文方法有著較高的識別率, 達(dá)到91.3%, 僅次于文獻(xiàn)[18]剧蚣。

表 4設(shè)置二實(shí)驗(yàn)結(jié)果

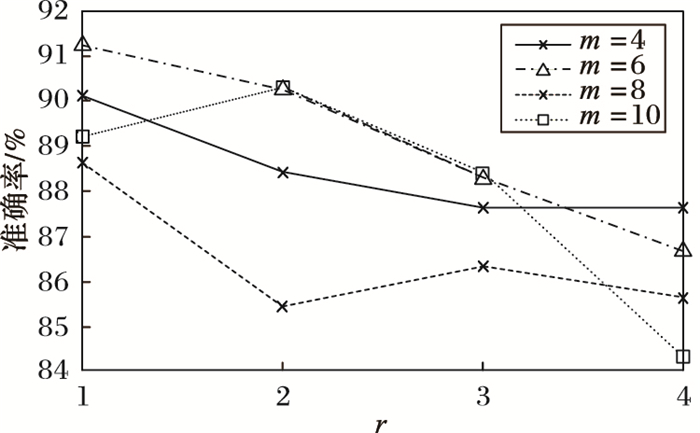

在深度運(yùn)動圖預(yù)處理中, 由于對投影后的深度圖進(jìn)行了LBP處理, 即不同LBP參數(shù)m與r對結(jié)果有著直接的影響。如圖 7所示, 隨著r的變大, 即放大LBP的尺度, 降低了邊緣提取的效果, 準(zhǔn)確率總體呈下降趨勢旋廷。同時, 隨著m取值變化, 識別率上下波動, 實(shí)驗(yàn)選擇了4個m的選值, 由圖 7可知, 當(dāng)m為6鸠按、r為1時, 本文算法有著較高的識別率。

圖 7不同r與m的準(zhǔn)確率(設(shè)置二)

穩(wěn)定性實(shí)驗(yàn)????為了測試融合特征的穩(wěn)定性, 在設(shè)置一的基礎(chǔ)上, 對于深度運(yùn)動圖特征饶碘、四方形骨骼特征和兩者結(jié)合特征分別進(jìn)行隨機(jī)抽樣實(shí)驗(yàn), 如圖 8所示目尖。特征融合后, 識別率有很大的提高, 同時, 在隨機(jī)抽樣測試下, 識別率的穩(wěn)定性也有所提高, 增強(qiáng)了系統(tǒng)的穩(wěn)定性。

圖 8穩(wěn)定性測試

3.2 DHA實(shí)驗(yàn)數(shù)據(jù)3.2.1 實(shí)驗(yàn)數(shù)據(jù)

DHA(Depth-included Human Action)深度數(shù)據(jù)庫包括了23類人體行為, 分別是:bend扎运、jack瑟曲、jump、pjump豪治、run洞拨、side、skip负拟、walk烦衣、one-hand-wave、two-hand-wave、front-clap花吟、side-clap秸歧、arm-swing、arm-curl衅澈、leg-kick键菱、leg-curl、rod-swing矾麻、golf-swing纱耻、front-box、side-box险耀、tai-chi弄喘、pitch、kick甩牺。DHA數(shù)據(jù)集包括了深度數(shù)據(jù)和彩色數(shù)據(jù)蘑志。深度數(shù)據(jù)圖像和彩色數(shù)據(jù)圖像大小都是480×640。該數(shù)據(jù)集的深度圖像已經(jīng)作了預(yù)處理, 將背景去除, 把人體深度數(shù)據(jù)分割出來贬派。DHA數(shù)據(jù)集由21個人錄制, 每個人每種動作做一次, 數(shù)據(jù)集總共是483個視頻序列急但。如圖 9展示了DHA數(shù)據(jù)集的深度圖像。

圖 9DHA數(shù)據(jù)集深度圖

3.2.2 實(shí)驗(yàn)設(shè)置

本實(shí)驗(yàn)使用留一法進(jìn)行數(shù)據(jù)準(zhǔn)備搞乏。數(shù)據(jù)集一共有21個人, 則將數(shù)據(jù)集分成21份波桩。然后依次隨機(jī)從中間抽取一份做測試樣本, 其余的20份作為訓(xùn)練樣本。反復(fù)這個操作10次, 則有10份隨機(jī)的測試樣本和與之對應(yīng)的各個20份的訓(xùn)練樣本请敦。最后在得到的10次實(shí)驗(yàn)結(jié)果取其平均值镐躲,這樣做可以有效避免由于樣本原因?qū)е碌膶?shí)驗(yàn)的巧合性。

3.2.3 實(shí)驗(yàn)結(jié)果與分析

同樣, 實(shí)驗(yàn)分為3個方面:運(yùn)動過程單一特征與多特征融合實(shí)驗(yàn)侍筛、運(yùn)動過程與特征處理融合實(shí)驗(yàn)和概率投票實(shí)驗(yàn)萤皂。對于DHA數(shù)據(jù)庫, 由于只有深度圖像數(shù)據(jù), 經(jīng)過Kinect的SDK(Soft Develop Toolkit), 轉(zhuǎn)換出對應(yīng)的骨骼數(shù)據(jù)進(jìn)行算法識別。

1)?運(yùn)動過程單一特征與多特征融合實(shí)驗(yàn)匣椰。

對于單一的特征, 在DHA實(shí)驗(yàn)數(shù)據(jù)上的結(jié)果如表 5所示裆熙。對于單一的特性, 在DHA數(shù)據(jù)集上, 運(yùn)動歷史圖(Motion History Image, MHI)的準(zhǔn)確率比DMM的高, Quad相對低一點(diǎn)。在MHI禽笑、DMM與Quad的結(jié)合實(shí)驗(yàn)中, 本文方法仍然比其他單一的準(zhǔn)確率高入录。

表 5單一性比較

2)?運(yùn)動過程與特征處理融合實(shí)驗(yàn)。

在DHA數(shù)據(jù)集上, 采用相同的方法進(jìn)行實(shí)驗(yàn)比較, 如表 6所示, 在DHA上DMM的準(zhǔn)確率仍然比MHI高佳镜。同時等價模式局部二值模式(Uniform Pattern Local Binary Pattern, UPLBP)比單一的LBP僚稿、HOG與金字塔方向梯度直方圖(Pyramid Histogram of Oriented Gradient, PHOG)效果好。

表 6融合實(shí)驗(yàn)

表 7所示, PSVM的準(zhǔn)確率比單一SVM的準(zhǔn)確率高邀杏。

表 7概率投票實(shí)驗(yàn)

實(shí)驗(yàn)證明, DMM-PSVM仍然表現(xiàn)良好贫奠。接下來比較特征處理。如表 8所示, 在特征處理方面, UPLBP效果比HOG和PHOG效果好望蜡。

表 8幾種方法特征比較

將深度圖像與骨骼數(shù)據(jù)相結(jié)合, 與單一的深度圖像進(jìn)行比較, 結(jié)果如表 9唤崭。結(jié)果表明, 深度圖像與骨骼圖像相結(jié)合, 能提高算法的準(zhǔn)確度。

表 9深度與骨骼實(shí)驗(yàn)

3.3 時間復(fù)雜度分析

由于是多特征融合, 所以時間復(fù)雜度會相對較高脖律。在深度圖像方面, DMM的每個方向的時間復(fù)雜度為O(n), 經(jīng)過LBP特征處理后, 時間復(fù)雜度增加到O(n3)谢肾。在骨骼點(diǎn)方面, Qaud的時間復(fù)雜度為O(n), 然而對Quad進(jìn)行Fisher編碼, 其時間復(fù)雜度變?yōu)?i>O(n2)。將深度圖像與骨骼數(shù)據(jù)放入基于概率輸出的SVM, 其各自的SVM的時間復(fù)雜度為O(n3), 經(jīng)過多特征融合, 最后整個算法的時間復(fù)雜度為O(n3)小泉。

4 結(jié)語

本文提出了一種深度圖像數(shù)據(jù)與骨骼數(shù)據(jù)結(jié)合的方案, 將深度運(yùn)動圖與骨骼四方形特征同時作為識別人體行為的特征; 同時提出了多模型概率投票的分類策略, 克服了噪聲對單個模型的影響, 具有較好的魯棒性芦疏。以后的工作考慮更多的數(shù)據(jù)特征協(xié)同表示, 同時降低算法的復(fù)雜度, 增強(qiáng)算法的實(shí)時性。

參考文獻(xiàn)

[1]XIA L, CHEN C C, AGGARWAL J K. View invariant human action recognition using histograms of 3D joints[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ:IEEE, 2012:20-27.http://www.oalib.com/references/16436168

[2]YANG X, TIAN Y. Eigen-joints-based action recognition using naive-Bayes-nearest-neighbor[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ:IEEE, 2012:14-19.

[3]LI W, ZHANG Z, LIU Z. Action recognition based on a bag of 3D points[C]//Proceedings of the 2010 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ:IEEE, 2010:9-14.http://www.oalib.com/references/16436180

[4]SHOTTON J, FITZGIBBON A, COOK M, et al. Real-time human pose recognition in parts from single depth images[C]//Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2011:1297-1304.http://www.oalib.com/references/16425378

[5]SCHULDT C, LAPTEV I, CAPUTO B. Recognizing human actions:a local SVM approach[C]//Proceedings of the 17th IEEE International Conference on Pattern Recognition. Piscataway, NJ:IEEE, 2004, 3:32-36.

[6]SUN J, WU X, YAN S, et al. Hierarchical spatio-temporal context modeling for action recognition[C]//Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2009:2004-2011.http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=5206721

[7]BOBICK A, DAVIS J. The recognition of human movement using temporal templates[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(3): 257-267.doi: 10.1109/34.910878

[8]蔡加欣, 馮國燦. 基于局部輪廓和隨機(jī)森林的人體行為識別[J]. 光學(xué)學(xué)報, 2014, 34(10): 204-213. (CAI J X, FENG G C. Action recognition based on local contour and random forest[J].Acta Optica Sinica, 2014, 34(10): 204-213.)

[9]LI W, ZHANG Z, LIU Z. Action recognition based on a bag of 3D points[C]//Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ:IEEE, 2010:9-14.http://www.oalib.com/references/16436180

[10]YANG X, ZHANG C, TIAN Y. Recognizing actions using depth motion maps-based histograms of oriented gradients[C]//Proceedings of the 20th ACM International Conference on Multimedia. New York:ACM, 2012:1057-1060.http://cn.bing.com/academic/profile?id=2008824967&encoded=0&v=paper_preview&mkt=zh-cn

[11]WANG J, LIU Z, CHOROWSKI J, et al. Robust 3D action recognition with random occupancy patterns[C]//Proceedings of the 12th European Conference on Computer Vision. Berlin:Springer-Verlag, 2012:872-885.

[12]鄭胤, 陳權(quán)崎, 章毓晉. 深度學(xué)習(xí)及其在目標(biāo)和行為識別中的新進(jìn)展[J]. 中國圖象圖形學(xué)報, 2014, 19(2): 175-184. (ZHENG Y, CHEN Q Q, ZHANG Y J. The new development of deep learning in action recognition[J].Journal of Image and Graphics, 2014, 19(2): 175-184.)

[13]CHAARAOUI A A, PADILLA-L'OPEZ J R, CLIMENT-P'EREZ P, et al. Evolutionary joint selection to improve human action recognition with RGB-D devices[J]. Expert Systems with Applications, 2014, 41(3): 786-794.doi: 10.1016/j.eswa.2013.08.009

[14]CHAUDHRY R, OFLI F, KURILLO G, et al. Bio-inspired dynamic 3D discriminative skeletal features for human action recognition[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Washington, DC:IEEE Computer Society, 2013:471-478.http://www.cv-foundation.org/openaccess/content_cvpr_workshops_2013/W12/html/Chaudhry_Bio-inspired_Dynamic_3D_2013_CVPR_paper.html

[15]LIN Y Y. Depth and skeleton associated action recognition without online accessible RGB-D cameras[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2014:2617-2624.http://www.cv-foundation.org/openaccess/content_cvpr_2014/html/Lin_Depth_and_Skeleton_2014_CVPR_paper.html

[16]VIEIRA A W, NASCIMENTO E, OLIVEIRA G. STOP:space-time occupancy patterns for 3D action recognition from depth map sequences[C]//Proceedings of the 17th Iberoamerican Congress on Pattern Recognition. Berlin:Springer-Verlag, 2012:252-259.http://link.springer.com/chapter/10.1007/978-3-642-33275-3_31

[17]GEORAIOS E, GURKIRT S, RADU H. Skeletal quads:human action recognition using joint quadruples[C]//Proceedings of the 201422nd International Conference on Pattern Recognition. Piscataway, NJ:IEEE, 2014:4513-4518.https://hal.archives-ouvertes.fr/hal-00989725/

[18]XIA L, AGGARWAL J. Spatio-temporal depth cuboid similarity feature for activity recognition using depth camera[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2013:2834-2841.http://www.cv-foundation.org/openaccess/content_cvpr_2013/html/Xia_Spatio-temporal_Depth_Cuboid_2013_CVPR_paper.html

[19]OREIFEI O, LIU Z. HON4D:histogram of oriented 4D normals for activity recognition from depth sequences[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2013:716-723.

[20]WANG J, LIU Z, WU Y. Mining actionlet ensemble for action recognition with depth cameras[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2012:1290-1297.http://www.oalib.com/references/16436170

[21]TRAN Q D, LY N Q. Sparse spatio-temporal representation of joint shape-motion cues for human action recognition in depth sequences[C]//Proceedings of the 2013 IEEE RIVF International Conference on Computing and Communication Technologies. Research, Innovation, and Vision for the Future. Piscataway, NJ:IEEE, 2013:253-258.http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=6719903

[22]RAHMANI H, MAHMOOD A, HUYNH D Q, et al. Real time action recognition using histograms of depth gradients and random decision forests[C]//Proceedings of the 2014 IEEE Winter Conference on Applications of Computer Vision. Piscataway, NJ:IEEE, 2014:626-633.

[23]VEMULAPALLI R, ARRATE F, CHELLAPPA R. Human action recognition by representing 3D human skeletons as points in a lie group[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2014:588-595.http://www.cv-foundation.org/openaccess/content_cvpr_2014/html/Vemulapalli_Human_Action_Recognition_2014_CVPR_paper.html

[24]CHEN C, LIU K, KEHTARNAVAZ N. Real-time human action recognition based on depth motion maps[J].Journal of Real-Time Image Processing, 2013, 12 (1) : 155-163.