-

關(guān)注醫(yī)學(xué)影像AI义屏,計算機(jī)輔助檢測,診斷蜂大,三維建模等闽铐; 關(guān)注互聯(lián)網(wǎng)醫(yī)療大數(shù)據(jù)各個模塊:精準(zhǔn)醫(yī)療、智慧醫(yī)療奶浦、移動醫(yī)療兄墅、數(shù)字醫(yī)療、互聯(lián)網(wǎng)醫(yī)療澳叉、醫(yī)療云服務(wù)隙咸、大數(shù)據(jù)、醫(yī)學(xué)圖像成洗、物聯(lián)網(wǎng)五督、養(yǎng)老服務(wù)、遠(yuǎn)程醫(yī)療瓶殃、電子病歷充包、可穿戴設(shè)備等。 歡迎大家關(guān)注碌燕,投稿误证,交流學(xué)習(xí)!

-

-

徹底理解 tf.reduce_sum()

reduce_sum() 用于計算張量tensor沿著某一維度的和,可以在求和后降維慈鸠。 input_tensor:待求和的tensor; axis:指定的維蓝谨,如果不指定,則計...

-

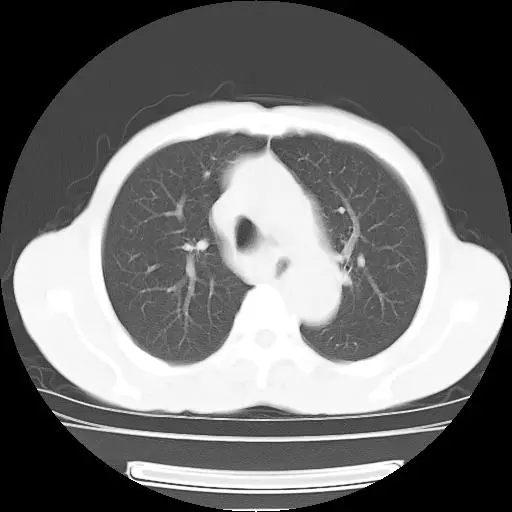

CT的窗口技術(shù)

越是簡單的技術(shù)越應(yīng)該引起重視青团,CT的窗口技術(shù)看似簡單譬巫,其實蘊(yùn)藏著豐富的知識。了解和熟練使用窗口技術(shù)對于CT的掃描和診斷非常有幫助督笆,今天我們就一塊兒了解一下窗口技術(shù)芦昔。 先來看個...

-

兩年菜鳥算法工程師的階段性總結(jié)

兩年菜鳥算法工程師的階段性總結(jié)不知不覺,筆者已經(jīng)做了在算法工程師這個熱門的崗位已經(jīng)兩年了娃肿。筆者本身學(xué)習(xí)的化工專業(yè)咕缎。當(dāng)年畢業(yè)不知道是因為打心底熱愛算法,還是因為圖這個崗位所能帶來的錢財料扰,總之凭豪,在花了兩年的時...

-

思想上遺世獨(dú)立,身體上同流合污

-

Kaggle提升模型性能的超強(qiáng)殺招Stacking——機(jī)器學(xué)習(xí)模型融合

Kaggle提升模型性能的超強(qiáng)殺招Stacking——機(jī)器學(xué)習(xí)模型融合之前的文章中談到了機(jī)器學(xué)習(xí)項目中嫂伞,要想使得使得機(jī)器學(xué)習(xí)模型進(jìn)一步提升,我們必須使用到模型融合的技巧拯钻,今天我們就來談?wù)勀P腿诤现斜容^常見的一種方法——stacking帖努。翻譯成中...

-

浙江大學(xué)生物醫(yī)學(xué)工程<br>碩士在讀<br>自然語言處理 iOS開發(fā)

-

xgboost原理及調(diào)參方法-通俗易懂版本

xgboost原理及調(diào)參方法-通俗易懂版本??xgboost是各種比賽中最常使用的方法然磷,網(wǎng)上介紹非常多,但是大部分看起來都比較費(fèi)勁刊驴,這篇文章我將通俗的講一下xgboost是在干什么姿搜,是怎么實現(xiàn)的,每一步的細(xì)節(jié)中要注意...

-

深入理解BP神經(jīng)網(wǎng)絡(luò)

深入理解BP神經(jīng)網(wǎng)絡(luò)一捆憎、BP神經(jīng)網(wǎng)絡(luò)的概念 BP神經(jīng)網(wǎng)絡(luò)是一種多層的前饋神經(jīng)網(wǎng)絡(luò)舅柜,其主要的特點(diǎn)是:信號是前向傳播的,而誤差是反向傳播的躲惰。具體來說致份,對于如下的只含一個隱層的神經(jīng)網(wǎng)絡(luò)模型: BP神經(jīng)...

-

您好,網(wǎng)頁打不開是為什么呢

訪問遠(yuǎn)程Visdom

1. 連接ssh時础拨,將服務(wù)器的8097端口重定向到自己機(jī)器上來: 其中:18097:127.0.0.1代表自己機(jī)器上的18097號端口氮块,8097是服務(wù)器上visdom使用的端...

-

RuntimeError: CUDA out of memory

最近使用GPU訓(xùn)練一個用PyTorch寫的神經(jīng)網(wǎng)絡(luò)模型绍载,網(wǎng)絡(luò)比較深,有100層左右滔蝉,訓(xùn)練部分的時候沒什么問題击儡,然而開始測試/驗證環(huán)節(jié)的時候,雖然我用了torch.cuda.e...

-

【框架語言】Pytorch六大學(xué)習(xí)率調(diào)整策略

PyTorch學(xué)習(xí)率調(diào)整策略通過torch.optim.lr_scheduler接口實現(xiàn)蝠引。PyTorch提供的學(xué)習(xí)率調(diào)整策略分為三大類阳谍,分別是 a. 有序調(diào)整:等間隔調(diào)整(S...

-

深度可分離卷積計算量與參數(shù)量

深度可分離卷積計算量與參數(shù)量本文記錄的目的是方便自己學(xué)習(xí)和復(fù)習(xí),有誤之處請諒解螃概,歡迎指出矫夯。 從卷積神經(jīng)網(wǎng)絡(luò)登上歷史舞臺開始,經(jīng)過不斷的改進(jìn)和優(yōu)化吊洼,卷積早已不是當(dāng)年的卷積训貌,誕生了分組卷積(Group co...

-

kaggle注冊激活

kaggle注冊激活用outlook郵箱注冊了kaggle,但換了幾個瀏覽器都不出現(xiàn)驗證碼融蹂,激活不了 網(wǎng)上查有說要翻墻的旺订,有一篇說安裝google訪問助手,于是就嘗試安裝google訪問助手 h...