-

ClickHouse在京東能源管理平臺的實踐

ClickHouse在京東能源管理平臺的實踐本文首次發(fā)表在京東云IoT專欄,原文地址https://developer.jdcloud.com/article/1423?mid=12[https://developer...

-

@搖曳在黃昏 你好大审,我這邊推送千萬甚至上億級別的數(shù)據(jù)蘸际,沒有出現(xiàn)過這個問題。從日志看徒扶,視乎是由于設(shè)置的提交批大小比Phoenix端的配置大導(dǎo)致的報錯粮彤。嘗試將batchsize設(shè)置更小,和你Phoenix集群的設(shè)置大小匹配姜骡。

通過JDBC方式將Spark RDD/DataFrame分布式寫入Phoenix

背景 在實際應(yīng)用場景导坟,出于安全等方面考慮,有時候大數(shù)據(jù)平臺不暴露對Phoenix的zookeeper url連接方式圈澈,本文提供一種基于jdbc的方式實現(xiàn)spark將Spark...

-

@搖曳在黃昏 如果不是自己搭建的spark乍迄,建議別改spark源碼打包,開發(fā)spark app士败,我們通常的做法是不把spark打包到j(luò)ar的闯两,直接使用集群環(huán)境。本文是直接仿照spark的dbuyil源碼實現(xiàn)的谅将,不需要修改源碼漾狼。

通過JDBC方式將Spark RDD/DataFrame分布式寫入Phoenix

背景 在實際應(yīng)用場景,出于安全等方面考慮饥臂,有時候大數(shù)據(jù)平臺不暴露對Phoenix的zookeeper url連接方式逊躁,本文提供一種基于jdbc的方式實現(xiàn)spark將Spark...

-

這是筆者考慮掉df上分區(qū)數(shù)太少,并行度不夠隅熙,采用的對dataframe進行重分區(qū)處理稽煤。大家調(diào)用的時候直接傳入df也是可以的核芽。

通過JDBC方式將Spark RDD/DataFrame分布式寫入Phoenix

背景 在實際應(yīng)用場景,出于安全等方面考慮酵熙,有時候大數(shù)據(jù)平臺不暴露對Phoenix的zookeeper url連接方式轧简,本文提供一種基于jdbc的方式實現(xiàn)spark將Spark...

-

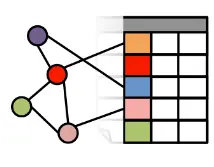

人工神經(jīng)網(wǎng)絡(luò)

人工神經(jīng)網(wǎng)絡(luò)一、概念 本文討論的神經(jīng)網(wǎng)絡(luò)是從生物學領(lǐng)域引入計算機科學和工程領(lǐng)域的一個仿生學概念匾二,又稱人工神經(jīng)網(wǎng)絡(luò)(英語:artificial neural network哮独,縮寫ANN)。...

-